Google anunció una tecnología innovadora llamada CALM que acelera los modelos de lenguaje grandes (como GPT-3 y LaMDA) sin comprometer los niveles de rendimiento.

Los datos de entrenamiento más grandes son mejores, pero tienen un costo

Los modelos de lenguaje grande (LLM) se entrenan con grandes cantidades de datos.

Entrenar los modelos de lenguaje en grandes cantidades de datos da como resultado que el modelo aprenda nuevas habilidades que no siempre están planificadas.

Por ejemplo, agregar más datos de entrenamiento a un modelo de idioma puede resultar inesperadamente en que obtenga la capacidad de traducir entre diferentes idiomas, aunque no haya sido entrenado para hacerlo.

Estas nuevas habilidades se denominan habilidades emergentes, habilidades que no están necesariamente planificadas.

Un artículo de investigación diferente ( PDF ) sobre habilidades emergentes afirma:

«Aunque hay docenas de ejemplos de habilidades emergentes, actualmente hay pocas explicaciones convincentes de por qué tales habilidades surgen de la forma en que lo hacen».

No pueden explicar por qué se aprenden diferentes habilidades.

Pero es bien sabido que aumentar la cantidad de datos para entrenar la máquina le permite adquirir más habilidades.

La desventaja de ampliar los datos de entrenamiento es que se necesita más potencia computacional para producir una salida, lo que hace que la IA sea más lenta en el momento en que genera una salida de texto (un momento que se denomina «tiempo de inferencia»).

Entonces, la compensación de hacer que una IA sea más inteligente con más datos es que la IA también se vuelve más lenta en el momento de la inferencia.

El nuevo trabajo de investigación de Google (PDF de modelado de lenguaje adaptativo seguro ) describe el problema de la siguiente manera:

“Los avances recientes en los modelos de lenguaje grande (LLM) basados en Transformer han llevado a mejoras de rendimiento significativas en muchas tareas.

Estas ganancias vienen con un aumento drástico en el tamaño de los modelos, lo que puede conducir a un uso lento y costoso en el momento de la inferencia”.

Modelado de lenguaje adaptativo seguro (CALM)

Los investigadores de Google encontraron una solución interesante para acelerar los modelos de lenguaje y al mismo tiempo mantener un alto rendimiento.

La solución, por hacer una analogía, es algo así como la diferencia entre responder una pregunta fácil y resolver una más difícil.

Una pregunta fácil, como de qué color es el cielo, puede responderse con poca reflexión.

Pero una respuesta difícil requiere que uno se detenga y piense un poco más para encontrar la respuesta.

Computacionalmente, los modelos de lenguaje grandes no distinguen entre una parte difícil de una tarea de generación de texto y una parte fácil.

Generan texto tanto para las partes fáciles como para las difíciles utilizando toda su potencia informática en el momento de la inferencia.

La solución de Google se llama Modelado de lenguaje adaptable seguro (CALM).

Lo que hace este nuevo marco es dedicar menos recursos a las partes triviales de una tarea de generación de texto y dedicar todo el poder a las partes más difíciles.

El trabajo de investigación sobre CALM establece el problema y la solución de esta manera:

“Los avances recientes en los modelos de lenguaje grande (LLM) basados en Transformer han llevado a mejoras de rendimiento significativas en muchas tareas.

Estas ganancias vienen con un aumento drástico en el tamaño de los modelos, lo que puede conducir a un uso lento y costoso en el momento de la inferencia.

En la práctica, sin embargo, la serie de generaciones realizadas por los LLM se compone de diferentes niveles de dificultad.

Si bien ciertas predicciones realmente se benefician de la capacidad total de los modelos, otras continuaciones son más triviales y se pueden resolver con un cálculo reducido.

…Si bien los modelos grandes funcionan mejor en general, es posible que no se requiera la misma cantidad de cómputo para que cada entrada logre un rendimiento similar (por ejemplo, dependiendo de si la entrada es fácil o difícil)”.

¿Qué es Google CALM y funciona?

CALM funciona mediante la asignación dinámica de recursos según la complejidad de la parte individual de la tarea, utilizando un algoritmo para predecir si algo necesita recursos totales o parciales.

El trabajo de investigación comparte que probaron el nuevo sistema para varias tareas de procesamiento de lenguaje natural («resumen de texto, traducción automática y respuesta a preguntas») y descubrieron que podían acelerar la inferencia en un factor de tres (300%). .

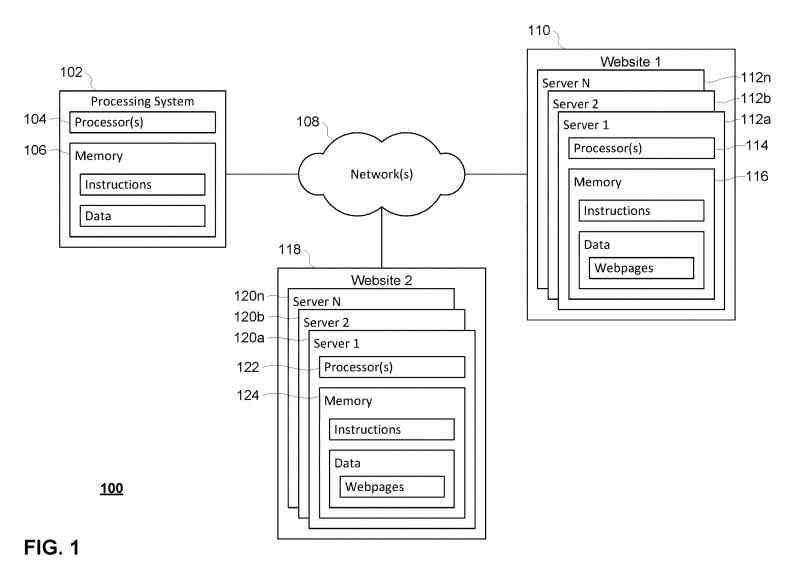

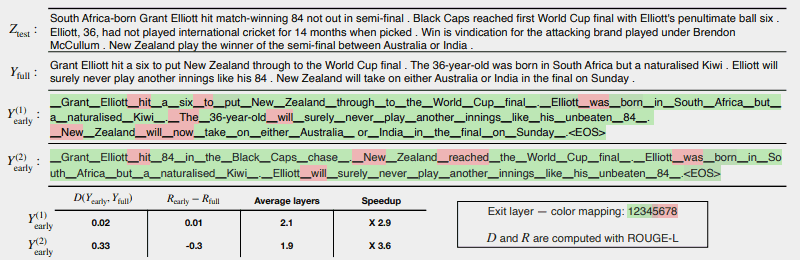

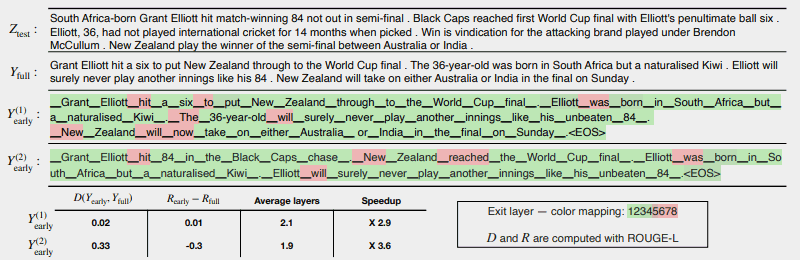

La siguiente ilustración muestra qué tan bien funciona el sistema CALM.

Las pocas áreas en rojo indican dónde la máquina tuvo que utilizar toda su capacidad en esa sección de la tarea.

Las áreas en verde son donde la máquina usó menos de la mitad de su capacidad.

Rojo = Capacidad total/Verde = Menos de la mitad de la capacidad

Esto es lo que dice el trabajo de investigación sobre la ilustración anterior:

Esto es lo que dice el trabajo de investigación sobre la ilustración anterior:

“CALM acelera la generación al salir temprano cuando sea posible y usar selectivamente la capacidad completa del decodificador solo para unos pocos tokens, demostrado aquí en un ejemplo de CNN/DM con una medida de confianza basada en softmax. Y (1) temprano y Y (2) temprano usan diferentes umbrales de confianza para la salida anticipada.

Debajo (sic) del texto, informamos la consistencia textual y de riesgo medida de cada uno de los dos resultados, junto con las ganancias de eficiencia.

Los colores representan la cantidad de capas de decodificación utilizadas para cada token; los tonos verde claro indican menos de la mitad del total de capas.

Solo unas pocas fichas seleccionadas usan la capacidad total del modelo (coloreadas en rojo), mientras que para la mayoría de las fichas el modelo sale después de una o pocas capas de decodificación (coloreadas en verde)”.

Los investigadores concluyeron el artículo señalando que implementar CALM requiere solo modificaciones mínimas para adaptar un modelo de lenguaje grande para que sea más rápido.

Esta investigación es importante porque abre la puerta a la creación de modelos de IA más complejos que se entrenan en conjuntos de datos sustancialmente más grandes sin experimentar una velocidad más lenta y manteniendo un alto nivel de rendimiento.

Sin embargo, es posible que este método también pueda beneficiar a los modelos de lenguaje grandes que también se entrenan con menos datos.

Por ejemplo, los modelos InstructGPT, de los cuales ChatGPT es un modelo hermano, se entrenan en aproximadamente 1300 millones de parámetros, pero aún pueden superar a los modelos que se entrenan en muchos más parámetros.

Los investigadores señalaron en la conclusión:

“En general, nuestro completo marco de computación adaptativo para LM requiere modificaciones mínimas en el modelo subyacente y permite ganancias de eficiencia al tiempo que satisface rigurosas garantías de calidad para la salida”.

Esta información sobre este trabajo de investigación se acaba de publicar en el blog de IA de Google el 16 de diciembre de 2022. El trabajo de investigación en sí tiene fecha del 25 de octubre de 2022.

Será interesante ver si esta tecnología se abre camino en grandes modelos de lenguaje del futuro cercano.

Lea la publicación del blog de Google:

Aceleración de la generación de texto con modelado de lenguaje adaptativo seguro (CALM)

Lea el documento de investigación:

Modelado de lenguaje adaptativo seguro (PDF)

Imagen destacada de Shutterstock/Master1305