¿Alguna vez ha tenido un cliente (o jefe) que mencionó las discrepancias entre las herramientas de SEO que utiliza?

Como SEO, es difícil tener esa conversación. A nadie le gusta escuchar: «Bueno, todas estas herramientas miden las cosas de diferentes maneras y nunca son 100% …».

Para las personas que no son SEO, esto se siente como una escapatoria conveniente para responder una pregunta simple: «¿Por qué no pueden darme datos precisos?»

Habiendo tenido esta conversación tantas veces durante la última década, decidí que quería comparar los diferentes resultados entre las herramientas para determinar si había coherencias o generalizaciones que se pudieran hacer al informar y tomar decisiones.

Por ejemplo: quiero que un SEO pueda decir: “Según SEMrush, este es el número total de palabras clave de la página 1 para las que clasifica. Tenga en cuenta que SEMrush, en promedio, informa un número de palabras clave un 25% menor (o mayor) que la herramienta de SEO promedio «.

También quería poder demostrar que los datos de las herramientas de SEO no deben tomarse como un evangelio, sino que deben usarse para una amplia identificación de tendencias y un análisis rápido y sucio de la competencia.

Descargo de responsabilidad: esta investigación y sus resultados ciertamente no tienen la intención de favorecer o desacreditar ninguna herramienta de SEO en particular. Todos tienen áreas de fortaleza y debilidad, y cuando se usan para complementarse entre sí, pueden ser bastante poderosos. En esta prueba, solo estamos viendo tres salidas, por lo que es importante comprender las limitaciones de estos datos.

Veamos qué encontré …

Cómo se configuro la prueba

Observé tres métricas principales para comparar las herramientas:

- Vinculación de dominios raíz.

- Palabras clave orgánicas de dominio clasificadas del 1 al 10 en la búsqueda de EE.

- Bonificación: tráfico de búsqueda mensual estimado (trabajo en curso).

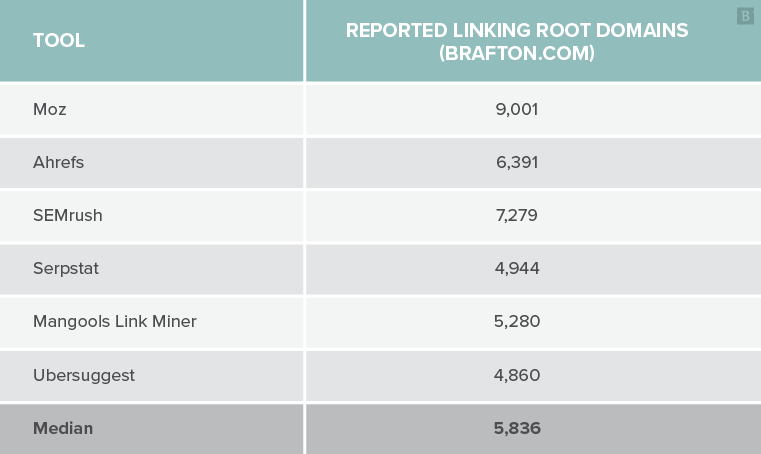

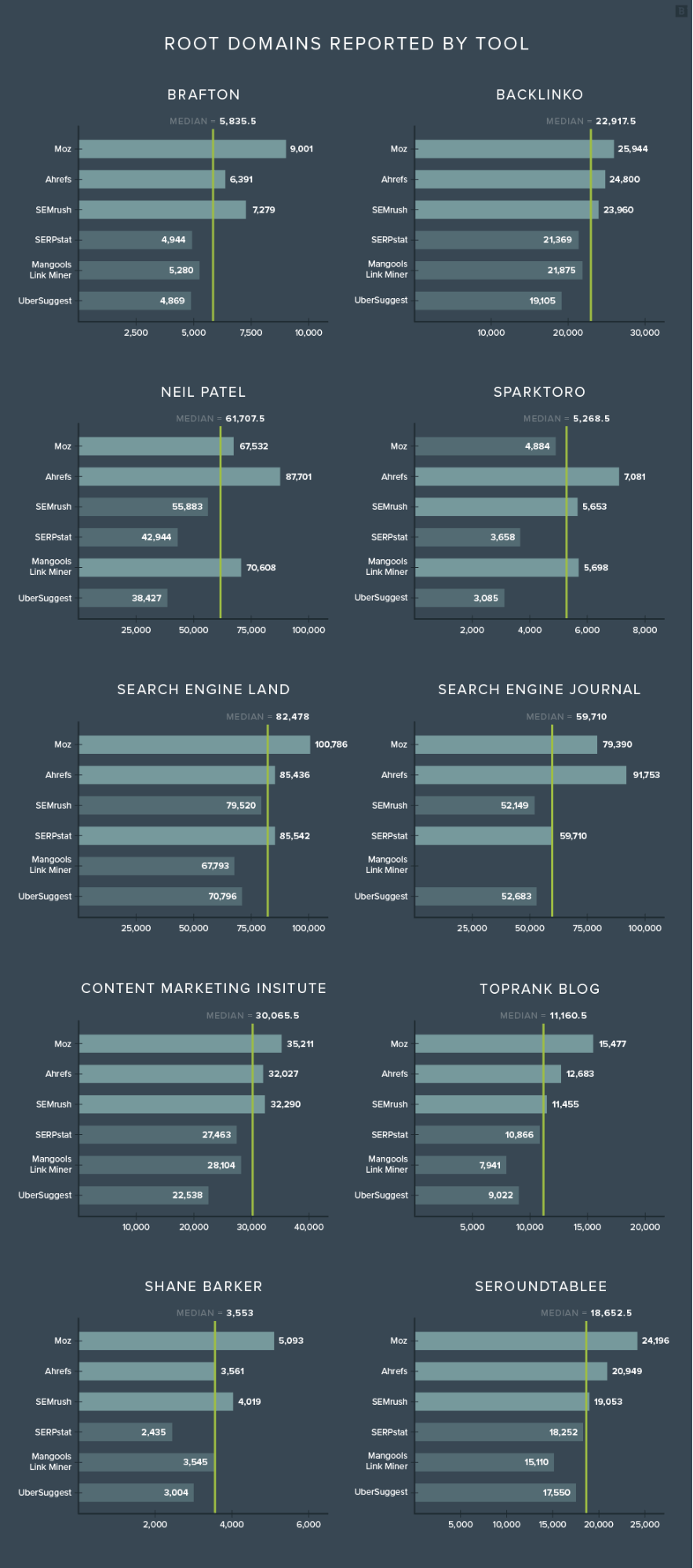

Tomé un sitio web y comparé los resultados de varias herramientas de SEO. Por ejemplo, el siguiente gráfico muestra lo que informó cada herramienta para el total de dominios raíz de enlaces de mi agencia:

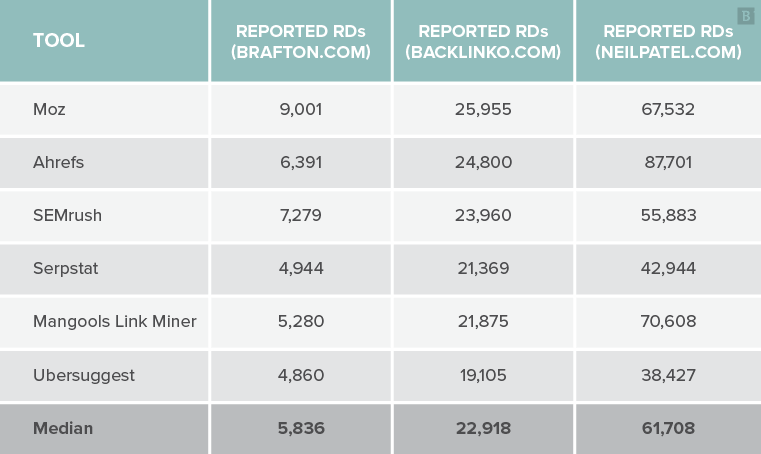

Luego agregué otros nueve dominios y comparé sus resultados para obtener un tamaño de muestra más grande. Ejemplo de tres dominios:

Luego comparé las diferencias de salida en relación con la mediana para cada herramienta y dominio para cada uno de los 10 dominios.

Por ejemplo, el número medio informado de dominios raíz para mi agencia fue de 5.836. Mangools reportó 5.280 DR, que es un 10% menos que la mediana.

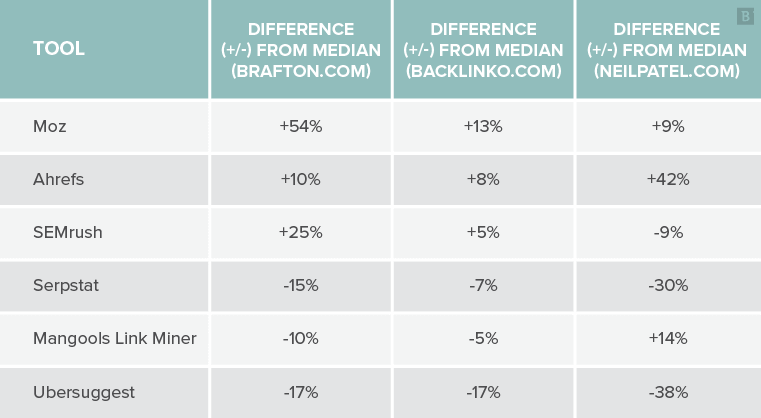

A continuación, se muestra un ejemplo de esta comparación con la mediana de los DR informados:

Lo que esto muestra es que Moz informó un mayor número de DR que la mediana de estos tres sitios. A la inversa, Ubersuggest informó menos DR que la mediana para cada uno de los mismos tres sitios. ¿Tener sentido?

Esta es una forma sencilla de responder a la pregunta: «¿La herramienta X generalmente informa más o menos datos que otras herramientas?»

Por último, calculé la diferencia promedio de la mediana para cada herramienta en cada sitio. Esto ayudó a responder la pregunta: “En cada uno de los 10 sitios evaluados, ¿qué herramientas (si las hay) informaron consistentemente números más bajos / más altos que la mediana? ¿Por cuanto?»

Este número único debería darnos una indicación de si una herramienta informa menos, los mismos o más datos que la mediana.

Calificaciones de estudio

En pruebas como esta, más datos siempre es mejor que menos. En este caso, he utilizado 10 dominios para intentar responder las preguntas anteriores. Ciertamente, un estudio a mayor escala arrojaría resultados más precisos, y tal vez un SEO ambicioso con más tiempo y recursos llevará a cabo dicho estudio algún día.

Por favor, comprenda que los siguientes datos están destinados a ser un iniciador de conversación en lugar de un final de conversación. Tiene la intención de pintar el comienzo de un cuadro en lugar de ser definitivo.

Calificaciones fuera del camino, echemos un vistazo a los resultados.

Dominios raíz

Vigilamos de cerca el número y la calidad de los dominios raíz que se vinculan a nuestros dominios porque los perfiles de vínculos de retroceso sólidos se correlacionan con el potencial de clasificación. También monitoreamos los perfiles de backlinks de nuestros competidores con fines de evaluación comparativa.

Por lo tanto, si tiene la intención de comparar su sitio con sus competidores, será un beneficio adicional saber si la herramienta que está utilizando generalmente reporta un número más bajo o más alto que otras herramientas. Como verá en los datos a continuación, también querrá asegurarse de usar la misma herramienta para comparar sitios.

Advertencia : Mangools informó un valor atípico del 392%, que sospecho que es un problema técnico. He omitido este valor atípico en un esfuerzo por mantener la representación de los datos.

Estos son los resultados de cada dominio:

Con solo mirar estos gráficos, puede ver que Moz tiende a informar un número significativamente mayor de dominios raíz que la mediana. Ubersuggest parece reportar consistentemente un número menor de dominios raíz que la mediana.

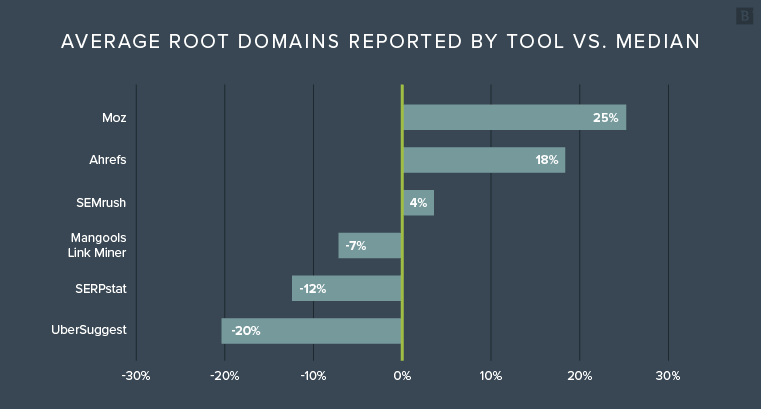

Así es como se ve el informe de dominio raíz de enlace promedio para cada una de las herramientas:

Entonces, ¿qué nos dice esta información?

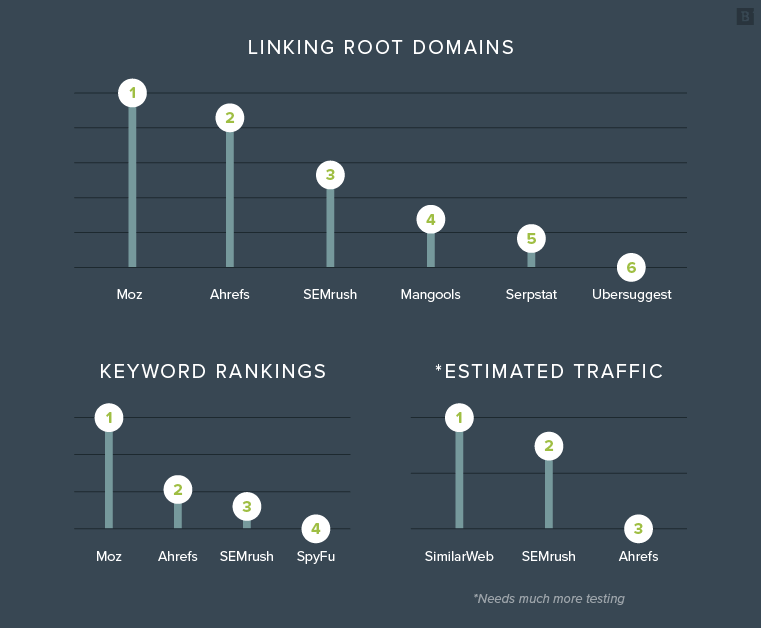

En promedio, Moz y Ahrefs informaron una mayor cantidad de dominios raíz que la competencia. SEMrush informó casi exactamente en la mediana. Mangools, SERPstat y Ubersuggest informaron relativamente menos dominios raíz que la mediana.

Si bien el tamaño de la muestra es pequeño, existe una tendencia claramente observable:

- Ahrefs informó más dominios raíz de enlace que la mediana del 100% del tiempo.

- Moz informó más dominios raíz de enlace que la media del 90% de las veces.

- Ubersuggest informó menos dominios raíz de enlace que la mediana del 100% del tiempo.

Con estos datos, podemos decir que es probable (no garantizado) que Moz y Ahrefs reporten más dominios raíz de enlace que las otras herramientas, mientras que Ubersuggest y hasta cierto punto SERPstat reportarán menos dominios raíz de enlace.

¿Esto hace que una herramienta sea mejor que otra? No necesariamente, pero seguro que agrega contexto.

Ganadores: Moz y Ahrefs

Clasificaciones de palabras clave

Quizás la métrica más accesible e interesante para nuestros clientes y jefes es el ranking de palabras clave. Quieren saber cuántas palabras clave clasifica su dominio y cómo se compara con sus competidores.

Una comprensión amplia de la propiedad de las palabras clave dentro de su espacio puede decirle mucho sobre el tamaño de su panorama de búsqueda y cómo está a la altura.

Si piensa en el panorama de las palabras clave como el tamaño de su mercado y la propiedad de las palabras clave como la cuota de mercado, comprenderá mejor dónde se encuentra ahora y dónde quiere estar en el futuro.

Sin embargo, las herramientas de SEO tienen una capacidad muy limitada para informar con precisión estos números. Si bien son sofisticadas, estas herramientas tienen que depender del raspado de Google para generar datos. Y la calidad de la salida de datos depende en gran medida de la potencia de la herramienta de raspado y del tamaño de su base de datos. Como verá pronto, los datos varían enormemente de una herramienta a otra.

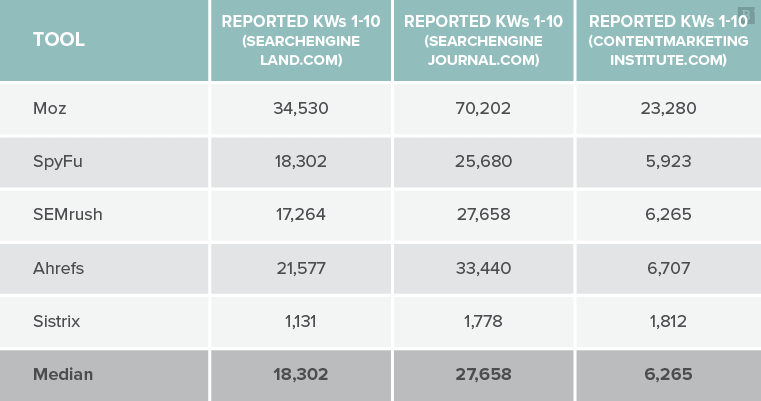

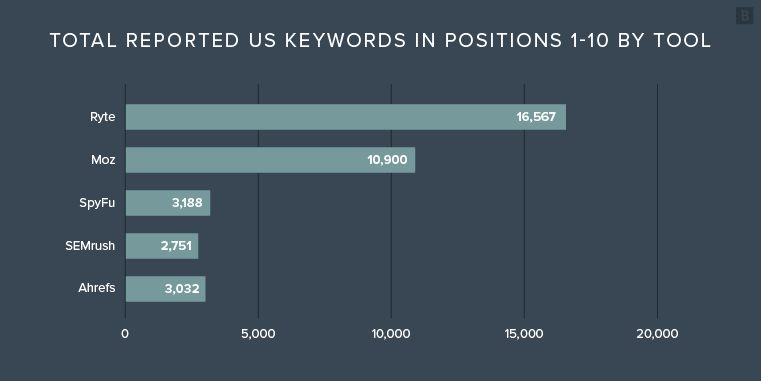

Todos los datos se recopilaron de manera idéntica. Saqué el número total de palabras clave clasificadas del 1 al 10 en las búsquedas en EE. UU. De cada una de las herramientas: Moz, Ahrefs, SpyFu, Sistrix y SEMrush. Desafortunadamente, tuve que dejar a Sistrix fuera del análisis final, ya que solo reportó el 11% de la mediana en general, distorsionando así el campo.

A continuación, se muestra un ejemplo de algunos de los datos:

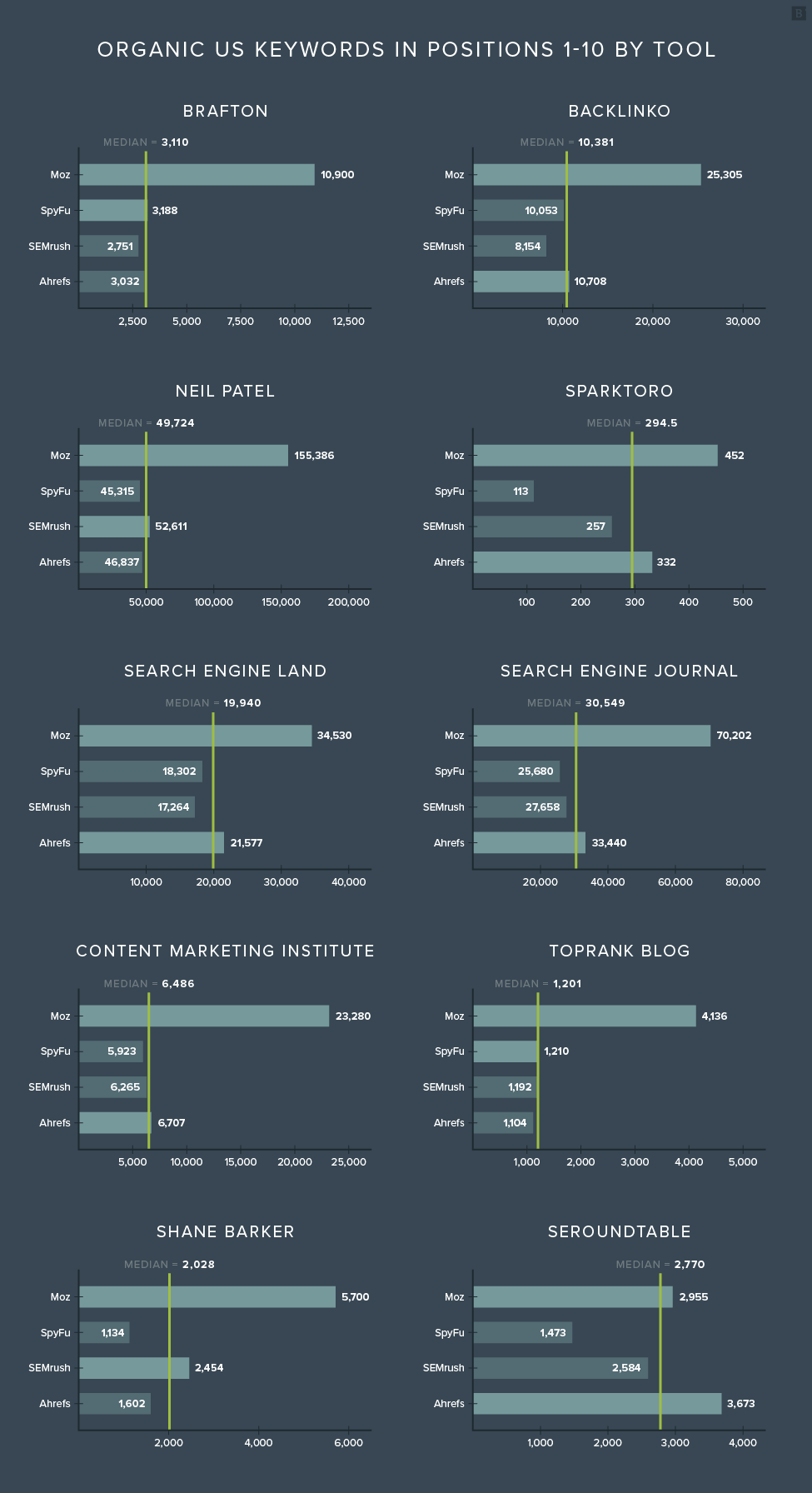

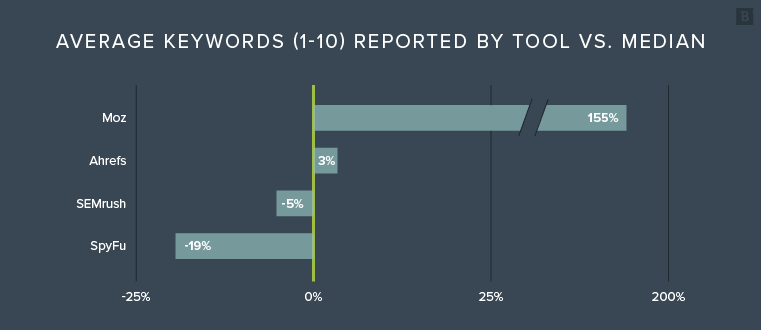

Como ya puede ver, hay MUCHA discrepancia en los datos y solo va a empeorar. Usando la misma técnica de comparar los informes de cada herramienta con la mediana, encontré lo siguiente:

Lo primero que te llama la atención es probablemente: «¿Qué está pasando con Moz?» Si bien Moz también informó un mayor número de dominios raíz de enlace que sus competidores en el estudio anterior, los números no eran lo suficientemente grandes como para romper el modelo. Aquí está el informe general contra la mediana:

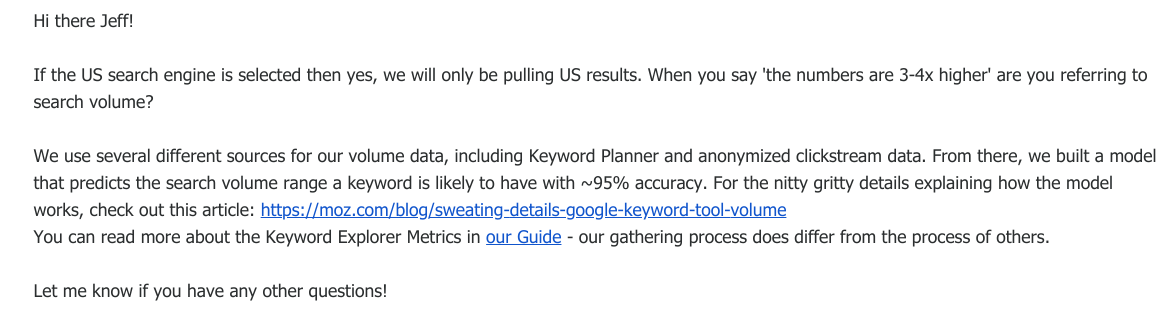

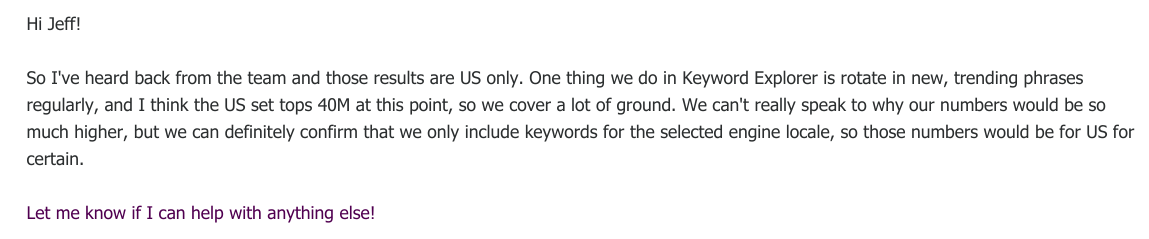

En este caso, Moz rompió el modelo. Mi preocupación inicial fue que Moz estaba informando clasificaciones de palabras clave en todo el mundo , en lugar de clasificaciones de palabras clave de EE. UU. Expresé esta preocupación con su equipo, a lo que respondieron:

Sin duda, les pedí que acudieran a sus ingenieros para su confirmación. Ellos respondieron:

Según el equipo de Moz, estos números están en el nivel.

Entonces, ¿qué nos dice esta información?

En promedio, Moz informó 2.5 veces más palabras clave que la mediana. Ahrefs aterrizó directamente en la mediana, con SEMrush muy cerca. SpyFu completa el grupo, llegando al 81% de la mediana, mientras que Sistrix fue omitido, reportando solo el 11% de la mediana.

Nuevamente, si bien el tamaño de la muestra es realmente pequeño, tenemos algunos marcadores claros:

- Moz superó la mediana el 100% de las veces.

- Sistrix superó la mediana del 0% del tiempo.

- Ahrefs y SEMrush mostraron un alto nivel de consistencia cerca de la mediana.

Si los expertos de Moz están en lo cierto, entonces podemos hacer una afirmación generalizada de que su herramienta probablemente reportará una mayor cantidad de palabras clave por dominio. También podemos decir que es probable (no garantizado) que Ahrefs y SEMrush reporten resultados similares y consistentes. También es probable que SpyFu genere menos resultados, y Sistrix poblará la menor cantidad.

Pero, ¿qué tan cerca están estos números de la verdad?

Es difícil de decir, porque estamos tratando de tomar una instantánea de un objetivo en movimiento. Las palabras clave entran y salen constantemente de los 10 resultados principales. Y en un día cualquiera, una herramienta puede mostrar la clasificación de una palabra clave en la posición 9, mientras que otra puede colocar simultáneamente la palabra clave en la posición 11.

Por esta razón, esta parte particular del estudio fue muy susceptible a inexactitudes, tanto por la naturaleza de tratar de localizar un objetivo en movimiento como por la variabilidad de las capacidades de raspado de cada herramienta.

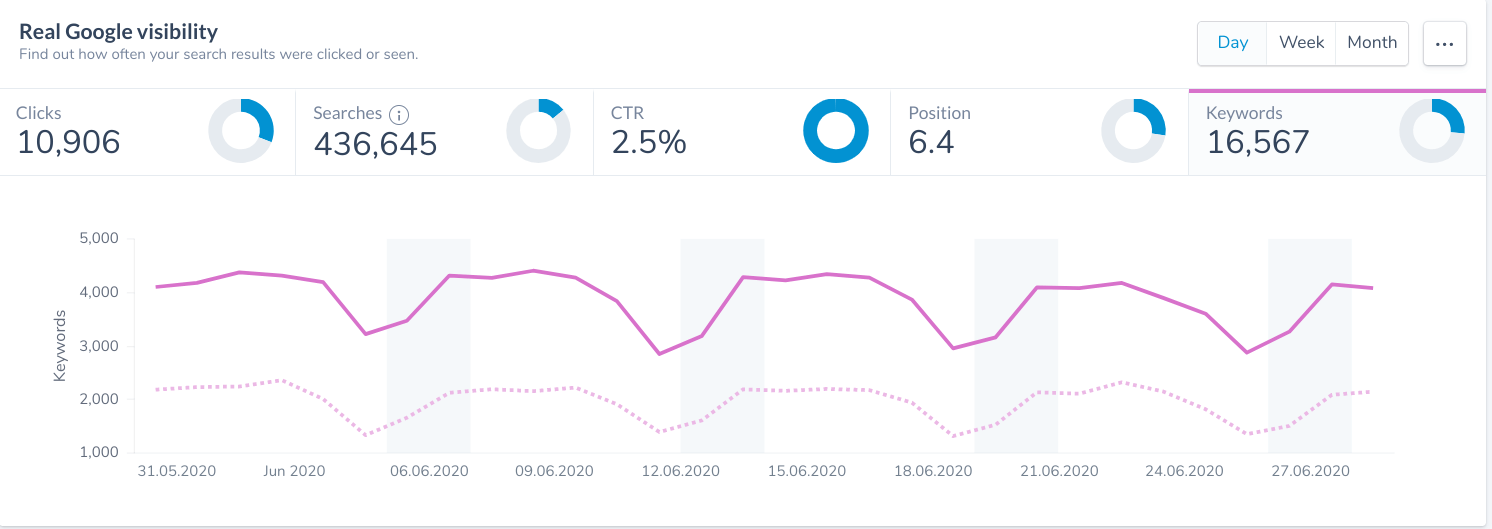

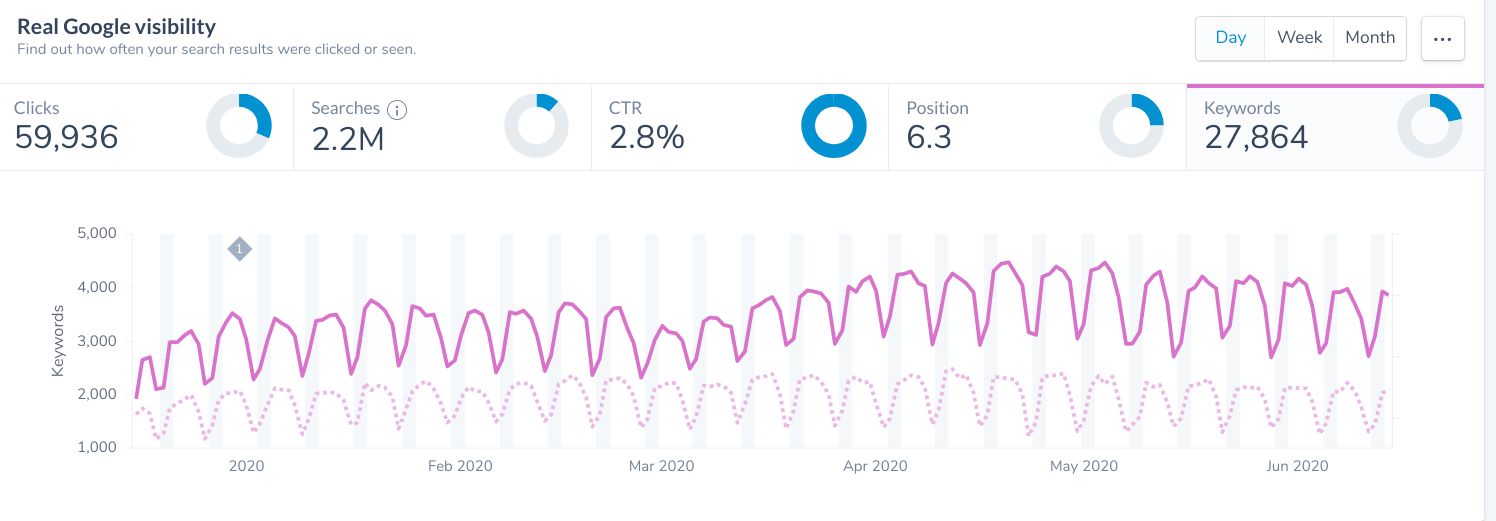

Afortunadamente, con un gran agradecimiento a Marcus Tandler y a la gente de Ryte , podemos ver el número real de palabras clave que clasifica nuestro sitio. Ryte es una herramienta sofisticada que integra todos los datos de la Consola de búsqueda de Google y los manipula de manera que le brinden datos verdaderos en lugar de datos extraídos.

Durante el mes de junio, Ryte muestra que Brafton en realidad se clasificó para 16.567 palabras clave en las posiciones 1 a 10 en los EE. UU.

La métrica mediana informada fue solo el 18,3% del número real durante un mes.

Y eso es solo un mes de datos.

Las herramientas de SEO acumulan su clasificación de palabras clave durante meses y años. Es decir, una de sus herramientas puede mostrar que actualmente se clasifica para una palabra clave que nadie ha buscado en años, ni ha generado impresiones.

Esta es la razón por la que una herramienta de palabras clave que hemos usado durante años podría informar que todavía clasificamos para cosas que ya nadie busca, como «Técnicas de investigación de palabras clave 2017».

Si extendimos el período de tiempo para incluir los primeros seis meses de 2020, generamos impresiones para 27,864 palabras clave.

Por lo tanto, en un mes determinado, a pesar de los mejores esfuerzos de cualquier herramienta, es posible que solo vea una fracción del número real.

¿Significa esto que las herramientas de SEO no están haciendo un buen trabajo? ¡Para nada!

De hecho, estas herramientas ciertamente priorizan palabras clave significativas y de mayor volumen en su base de datos sobre términos de cola más larga con un volumen de búsqueda significativamente menor. Pero también significa que debemos apreciar sus limitaciones y comprender que los números que estamos viendo no son perfectamente precisos.

Otro recordatorio de que debemos utilizar herramientas de SEO para análisis macro que nos brinden información general sobre las tendencias y la evaluación comparativa competitiva.

Ganador: Moz

Bono: tráfico estimado

Algunas herramientas de SEO intentan estimar la cantidad de visitantes orgánicos mensuales que genera un dominio. Al igual que en el estudio anterior, la estimación del tráfico de búsqueda orgánica puede ser una práctica útil de evaluación comparativa de la competencia y es una métrica increíblemente accesible para los clientes.

Desafortunadamente para este estudio, no existen muchas herramientas que hagan esto. Y menos aún que lo hagan con precisión.

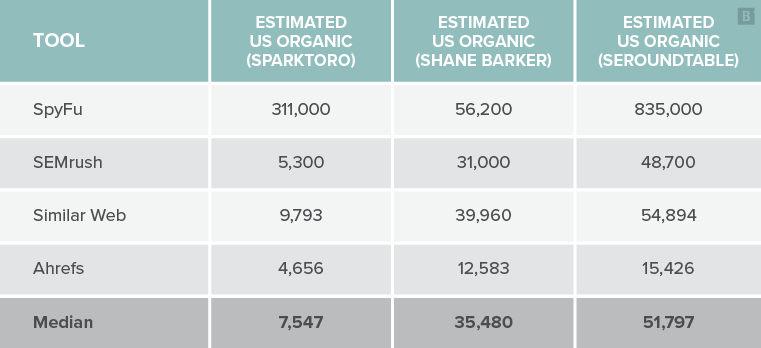

Al igual que en los estudios anteriores, recopilé datos de varias herramientas y mapeé su salida con el punto de datos medio. Saqué los visitantes orgánicos estimados de EE. UU. Para el mes de junio de 2020.

Desafortunadamente, esta vez tuvimos que omitir datos de SpyFu, ya que sobreestimó enormemente el tráfico de búsqueda a cada dominio en un promedio de 3,242% más. También tuve que omitir TopRank del análisis, ya que no todas las herramientas pudieron completar datos para este dominio.

A continuación, se muestra un ejemplo de algunos de los datos:

Puede ver de inmediato por qué tuve que omitir SpyFu del análisis. Con todo el respeto a la gente de SpyFu, ¡esta métrica en particular necesita una segunda mirada!

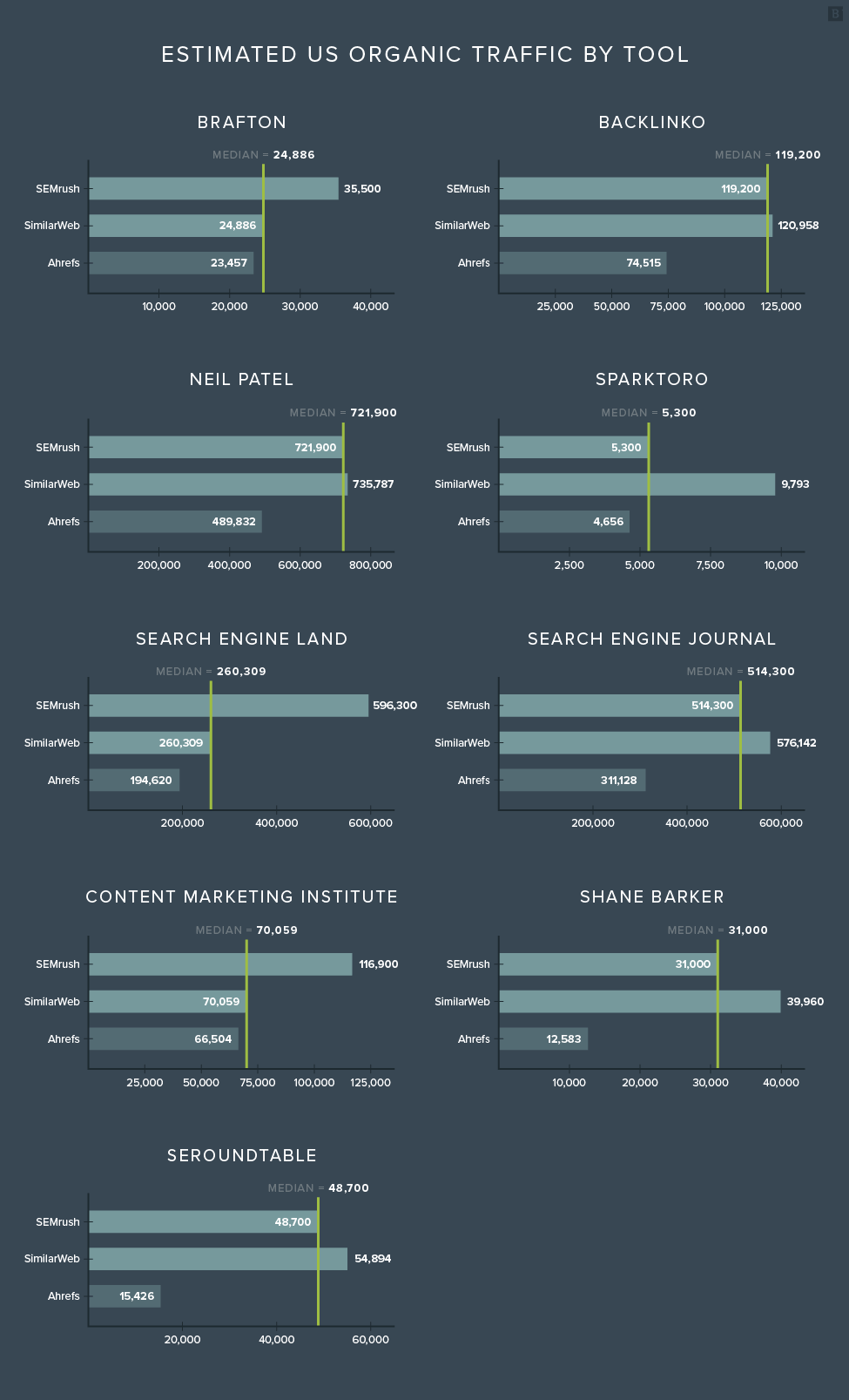

Para las tres herramientas restantes, así es como se veían los datos para cada dominio:

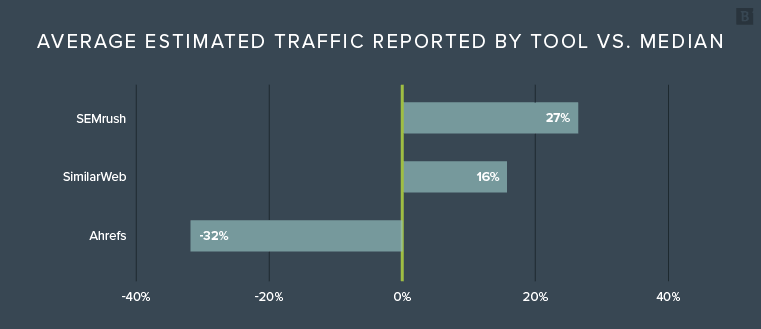

Y aquí están los números promedio reportados versus la mediana, por herramienta:

A diferencia de los dos estudios anteriores, en los que se podría argumentar que más datos es generalmente mejor, en este caso podría no ser el caso (como puede ver con los números de SpyFu).

En este caso, la precisión es clave. En promedio, Ahrefs informó cifras de tráfico estimadas mucho más bajas que SimilarWeb y SEMrush.

Pero realmente no tenemos idea de si alguno de estos números es bueno o malo sin contexto. Necesitamos números reales (precisos) para compararlos.

Afortunadamente, pude obtener números de tráfico reales de SparkToro.com, ShaneBarker.com y Brafton.com. Muchas gracias a Rand Fishkin y Shane por ayudar a que esto suceda.

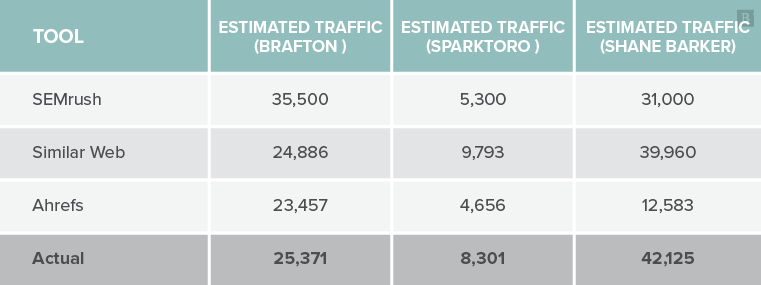

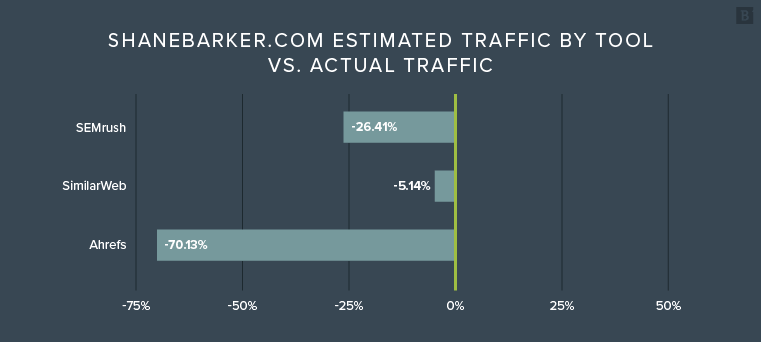

Aquí están las cifras estimadas frente a las cifras reales:

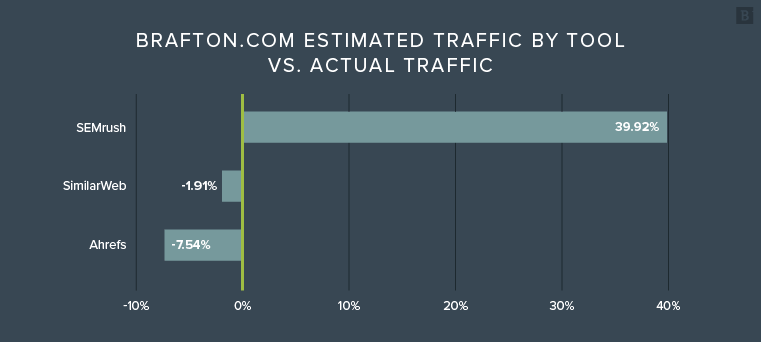

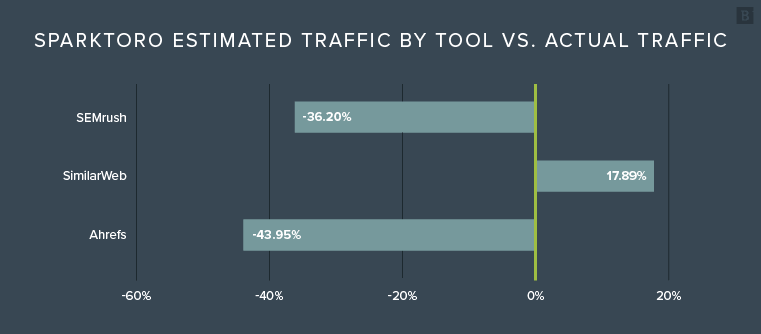

Echemos un vistazo a esto visualmente, comenzando con Brafton. Para leer los gráficos a continuación, considere la línea del 0% como el tráfico real, y cualquier número por encima del 0% como una sobreestimación de la herramienta, y cualquier valor por debajo como una subestimación.

Visualmente, parece que SimilarWeb se acercó al número real en cada una de las tres instancias. Ahrefs parece subestimar constantemente, mientras que SEMrush sobreestimará Y subestimará enormemente.

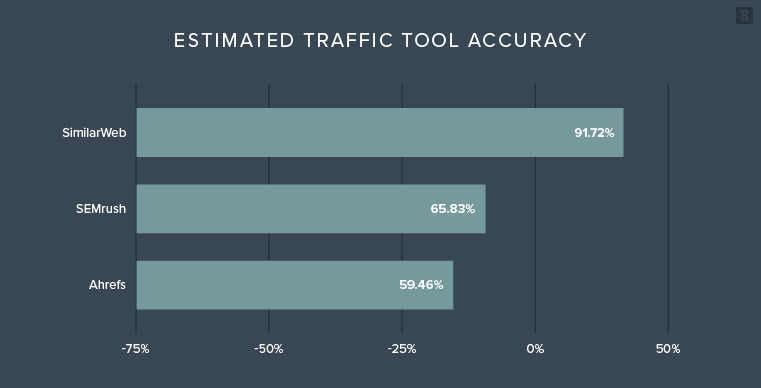

Para limpiar estos números, podemos tomar la precisión promedio general de cada herramienta promediando el porcentaje de sobrestimaciones y subestimaciones en relación con el número real. La precisión general por herramienta es la siguiente:

Advertencia importante aquí: necesitamos muchos más datos. Si bien es muy interesante ver cómo se compara cada herramienta con los números reales, no tenemos datos suficientes para sacar conclusiones. De un vistazo, PARECE que SimilarWeb estima con bastante precisión, con una precisión promedio del 91,7%.

¿Entonces qué nos dice esto?

SimilarWeb PUEDE informar estimaciones de tráfico ligeramente más precisas. Ahrefs PUEDE subestimar el tráfico en algunos casos. A partir de ahora, este análisis debe tomarse con un gran grano de sal y con un llamado a los otros seis sitios para obtener ayuda en este estudio.

Por ahora, digamos que estas herramientas muestran una variación significativa y, hasta nuevo aviso, deberíamos seguir llamando a esta métrica como es: Tráfico estimado.

Ganador: SimilarWeb en calor preliminar

Resumen

Nuevamente, con advertencias por todos lados, los ganadores de esta prueba de tamaño limitado son los siguientes:

La intención de este informe no era declarar todas las herramientas de SEO como inexactas e indignas de inversión. Tampoco fue la intención de elogiar las capacidades de las herramientas de alto rendimiento. Más bien, mi objetivo era demostrar las diferencias entre las herramientas para que pueda tener más contexto al usar sus números para informar.

Por ejemplo, si informa sobre la cantidad de dominios raíz de su sitio, es importante saber que Ubersuggest puede informar una cantidad significativamente menor que otras herramientas. Con eso en mente, es posible que desee hacer una advertencia sobre sus datos. También debe tener cuidado de no mezclar herramientas cuando utilice evaluaciones comparativas competitivas.

También debe decirles a sus clientes que las métricas informadas en estas herramientas no deben tomarse como evangelio. Deben utilizarse para análisis de tendencias generales y fines de evaluación comparativa de la competencia. Si se usa correctamente, cada una de estas herramientas puede ser enormemente reveladora.

Usados incorrectamente, pueden ser enormemente engañosos.